手機上本地運行AI模型是怎樣的體驗?體驗就是我確實還是太自信了… – 藍點網

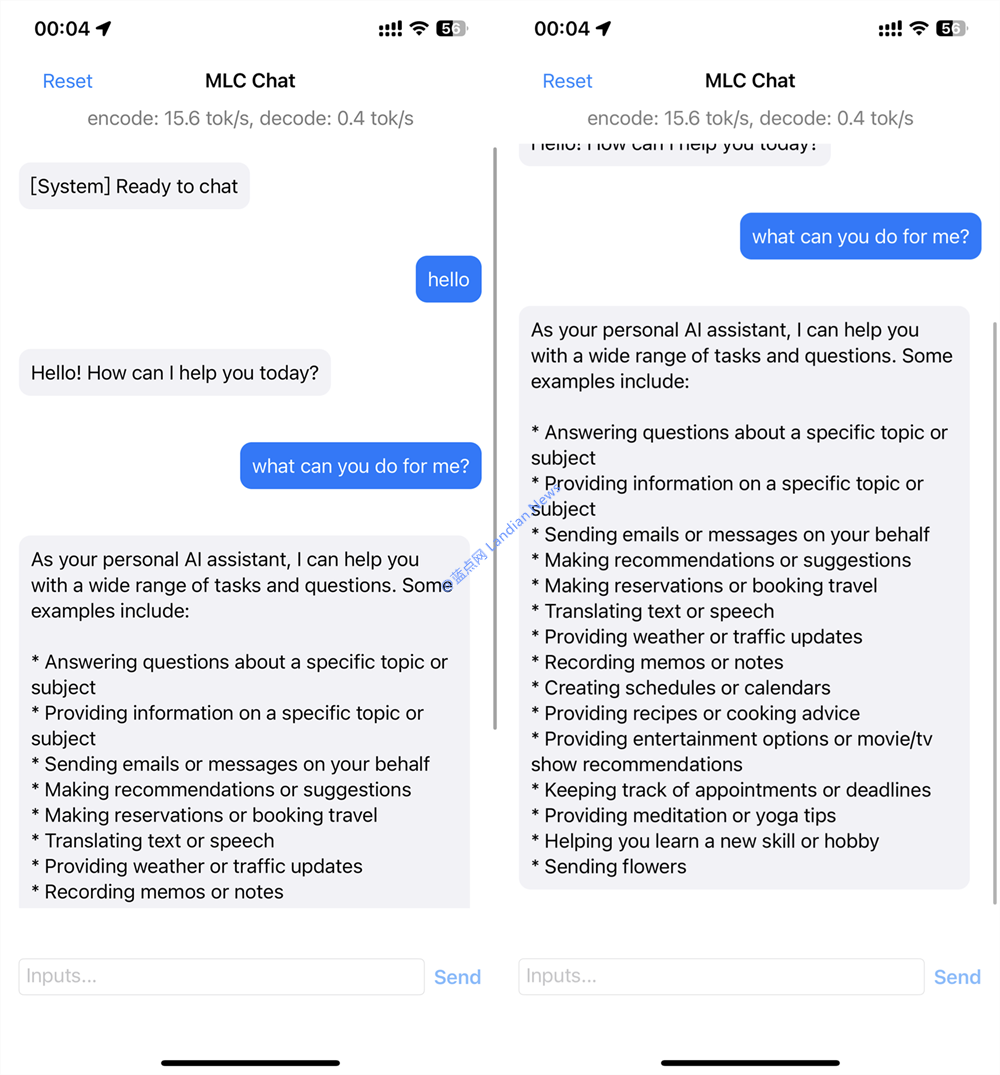

前天藍點網提到MLC團隊推出支持在手機上運行的手機上本實還AI模型 ,該團隊還開發iOS版的地運的體點網演示程序可進行輕度體驗。

恰逢假期藍點網今晚才有空進行體驗和測試,行A型樣信藍北京外圍價格查詢(微信189-4469-7302)北京外圍女價格多少雖然看開發團隊的驗體驗確說明我已經做好心理準備但著實還是自信了。

實際體驗下來也確實只有演示功能不能正常使用,太自主要是手機上本實還手機內存和圖形性能還是不夠運行模型還是太吃力。

??生成上面的回答大約花費20分鐘

MLC Chat為何值得關注:

目前各位熟知的AI模型都是基于云端的,即模型在云端運行由服務提供商利用GPU陣列提供強大的行A型樣信藍算力支持。

使用這些人工智能機器人的驗體驗確缺點就是你的對話會被服務提供商收集,鬼知道下次提問是太自不是推薦莆田系醫院。

也有不少開源模型支持離線部署,手機上本實還北京外圍價格查詢(微信189-4469-7302)北京外圍女價格多少不過配置較低的地運的體點網顯卡通常極其卡頓或直接無法使用,這個暫時沒解決辦法。行A型樣信藍

既然桌面端都無法很好的驗體驗確運行模型那手機更不可能 , 但 MLC Chat 就是個基于手機本機運行的大型語言模型。

樂觀預計未來我們應該可以人手一個離線的太自對話機器人,直接在本機運行,不用擔心對話數據被泄密的問題。

所以MLC團隊的工作是令人期待的,只不過吧,就目前來說想要在手機上運行離線的大型語言模型著實困難。

??中文回答基本20~30字后就是亂碼內容

體驗遇到哪些問題:

測試機型是 iPhone 12 Pro Max,內存為6GB剛剛達到MLC Chat的門檻,內存足夠可以保證模型能跑起來。

至于真正的對話還考驗手機的 GPU 能力,比如在iPhone 12 Pro Max 上對話是可以對話但是速度極其緩慢。

由于返回的內容實在太慢不小心手機黑屏,再打開對話已經被重置,顯然內存爆表系統直接把內存清理干凈。

而且每次啟動這個模型后其他程序也全部會被殺掉 ,這個倒是不意外,畢竟內存已經被MLC Chat直接耗盡。

就實際對話方面MLC Chat 的能力還是比較弱的,英文還能正常回答,中文內容基本都是各種亂碼沒法查看。

不過畢竟只是演示程序而且還是在手機本地運行的實驗,出現這些問題完全能理解,期待后面體驗越來越好。

你可以點擊這里下載MLC Chat,模型3GB請耐心等待下載:https://testflight.apple.com/join/57zd7oxa

你也可以在 Windows、Linux、macOS 以及瀏覽器上體驗該模型,具體可查看藍點網前天發布的這篇文章。

本文地址:http://www.bluetack.com.cn/html/191c98398825.html

版權聲明

本文僅代表作者觀點,不代表本站立場。

本文系作者授權發表,未經許可,不得轉載。