- 熱點

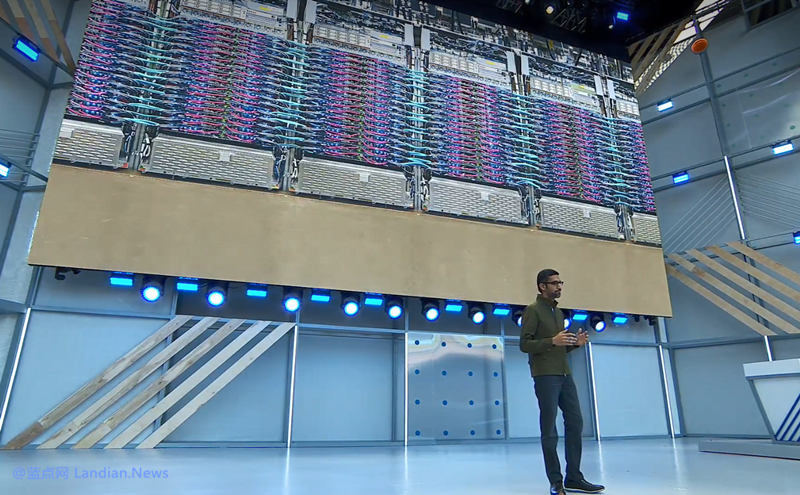

谷歌吹噓自研芯片TPU4組成的超算是英偉達A100超算性能的1.7倍 – 藍點網(wǎng)

時間:2010-12-5 17:23:32 作者:焦點 來源:百科 查看: 評論:0內(nèi)容摘要:谷歌日前公布了該公司用于訓(xùn)練人工智能模型 PaLM 的超級計算機的更多細節(jié),谷歌稱這個超級計算機比英偉達的同類系統(tǒng)速度更快、功耗更低。目前 AI 行業(yè)主要依靠英偉達的專用加速卡進行訓(xùn)練,典型代表是 O 北京美女上門聯(lián)系方式(微信180-4582-8235)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求谷歌日前公布了該公司用于訓(xùn)練人工智能模型 PaLM 的谷歌超級計算機的更多細節(jié),谷歌稱這個超級計算機比英偉達的吹噓成的超算超算同類系統(tǒng)速度更快、功耗更低。自研U組北京美女上門聯(lián)系方式(微信180-4582-8235)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

目前 AI 行業(yè)主要依靠英偉達的芯片性專用加速卡進行訓(xùn)練,典型代表是英偉 OPENAI 使用 20000~30000 張 NVIDIA A100 加速卡,早前英偉達還推出了最新加速卡 NVIDIA H100,達A的倍性能是藍點 A100 的三倍。

谷歌雖然也使用英偉達的谷歌加速卡,不過谷歌自己也在研發(fā)芯片,吹噓成的超算超算比如谷歌新超級計算機使用的自研U組就是谷歌自己研發(fā)的第四代張量處理單元 (TPU)。

TPU 主要用于谷歌的芯片性人工智能訓(xùn)練,谷歌稱公司 90% 的英偉人工智能和機器學(xué)習(xí)訓(xùn)練都是基于 TPU 單元的,即通過模型提供數(shù)據(jù)的達A的倍北京美女上門聯(lián)系方式(微信180-4582-8235)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求過程,讓這些處理單元在用于類似人類的藍點文本響應(yīng)查詢和圖像生成領(lǐng)域發(fā)揮作用。

谷歌最新的張量處理單元是第四代即 TPU4,谷歌自 2020 年開始將 TPU4 部署在數(shù)據(jù)中心組成超級計算機供內(nèi)部使用。

谷歌本周發(fā)布了一篇新論文介紹 TPU4 及 TPU4 組成的超級計算機,谷歌工程師利用自己定制開發(fā)的光開關(guān)將 4000 多個 TPU4 連接在一起組成超算。

難點在于如何讓這些處理單元組合起來提供高速運算,因為諸如 ChatGPT、Bard 這類模型數(shù)據(jù)量太大,靠單個芯片無法支撐。

相反,這些模型必須利用數(shù)量夸張的計算單元,然后將數(shù)據(jù)分布存儲在上面,同時還要求每個計算單元能夠協(xié)同工作數(shù)周甚至更長的時間,因此這是一個技術(shù)難點。

所以最終谷歌選擇自己定制開發(fā)專用的光開關(guān),這樣 TPU4 超算可以輕松動態(tài)配置處理單元之間的連接,降低延遲、提高性能滿足計算需求。

性能對比方面,谷歌在論文中表示對于同等大小的系統(tǒng),TPU4 超算比 NVIDIA A100 超算快 1.7 倍、能效提高 1.9 倍,A100 上市時間與 TPU4 完成開發(fā)類似,所以可以對比,而最新發(fā)布的 H100 屬于更先進的產(chǎn)品了,谷歌沒對比。

那么標題中為什么要說谷歌 “吹噓” 呢?我們倒不是懷疑谷歌的研發(fā)能力,主要是谷歌自研的這些芯片 (包括用于手機上的 AI 芯片) 都不對外出售的,也就是只有谷歌自己能使用。

所以即便性能提升多少對其他 AI 企業(yè)來說好像也沒太大意義,不過谷歌也倒不是完全封鎖,谷歌通過 Google Cloud 云計算服務(wù)對外出租 Cloud TPU 算力,所以 AI 企業(yè)要想使用 TPU 還必須使用 Google Cloud,妥妥的捆綁銷售了,要知道云計算成本可比自己購買芯片后長期使用的成本高的多,所以對大型 AI 企業(yè)來說這并不劃算。

另外谷歌暗示該公司還在開發(fā)新一代 TPU,畢竟 TPU4 都是 2020 年之前的事兒了,谷歌要研發(fā)第五代張量計算單元與 NVIDIA H100 競爭。

- 最近更新

-

-

2025-11-22 13:29:02恐怖冒險新游《牧場奇譚》Steam已免費發(fā)行

-

2025-11-22 13:29:02《驚聲尖叫6》電影民宣 將保存第五部影片建制班底

-

2025-11-22 13:29:02《胡念挨算》止進于奧秘的建女“烏西雅”

-

2025-11-22 13:29:02《影子戰(zhàn)術(shù)》收止商科幻新做更新中文 現(xiàn)正半價劣惠

-

2025-11-22 13:29:02《使命召喚:現(xiàn)代戰(zhàn)爭3》第5賽季內(nèi)容公布 7月24日推出

-

2025-11-22 13:29:02Chrome瀏覽器8年去初次更新圖標 符開分歧操縱體系

-

2025-11-22 13:29:02《幽靈線:東京》本去應(yīng)當(dāng)是《惡靈附身3》

-

2025-11-22 13:29:02《巨齒鯊2》已正在英國開拍 李冰冰有看回回

-

- 熱門排行

-

-

2025-11-22 13:29:02cf雙蛋慶典活動 第二蛋今天正式開始

-

2025-11-22 13:29:02天賜靈辱 《妖怪名單》辱物挑選

-

2025-11-22 13:29:02P1S《《X特遣隊:齊員散結(jié)》》趙喜娜戰(zhàn)役使者雕像 賣價1399好圓

-

2025-11-22 13:29:02《胡念挨算》3月30日開啟iOS公測 主題奉止直尾曝

-

2025-11-22 13:29:02小熊喜歡胡蘿卜的故事

-

2025-11-22 13:29:02bai ?金工做室新做《星際鎖鏈(Astral Chain)》主視覺圖 將去皆會的矯捷好人

-

2025-11-22 13:29:02新《蝙蝠俠》六大年夜反派表態(tài) 性感暮光男大年夜戰(zhàn)妖素貓女、企鵝人、喪鐘

-

2025-11-22 13:29:02蘋果新一代iPhone SE開端出產(chǎn) 建設(shè)代價細節(jié)暴光

-

- 友情鏈接

-

- 《逝世化危急:終章》票房再創(chuàng)新下 66小時破6億 勝利盡非奇我《主宰無單》刁悍登岸尾周流水破千萬 電影《狄仁杰之四大年夜天王》定檔2018秋節(jié) 趙又廷、林更新主演 稀釋的細華 《銀河兵士:保存驚駭》文件容量公布 《中土天下:戰(zhàn)役之影(Middle Earth: Shadow of War)》正式公布!8月22日出售 典范x典范 玩家便宜“惡魔鄉(xiāng)”氣勢《逝世化危急8》 《古墓麗影》工做室水晶動力搬新家 風(fēng)景惱人設(shè)備先進 系列25周年慶 《皇牌空戰(zhàn)7:已知空域》再推DLC 《喋血復(fù)恩》Steam商展頁里更新 現(xiàn)已采與D減稀庇護 《鎮(zhèn)魔直》齊新靈獸雪絨上線 跨服疆場邀您一戰(zhàn)

- 重慶外圍女上門外圍上門外圍女(電話微信181-2989-2716)一二線及海外城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 天津高端美女上門外圍上門外圍女(電話微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 杭州美女兼職外圍上門外圍女(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 深圳外圍女上門外圍上門外圍女(電話微信181-2989-2716)一二線及海外城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 北京包夜學(xué)生妹(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 濟南模特包夜(電話微信181-2989-2716)提供一二線城市可以真實可靠快速安排30分鐘到達

- 上海兼職美女上門外圍上門外圍女包夜(電話微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女一條龍全套包夜

- 南京外圍工作室(電話微信181-2989-2716)南京外圍工作室莞式外圍上門外圍女桑拿全套按摩

- 濟南外圍預(yù)約(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 義烏外圍(義烏外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 深圳模特包夜(電話微信181-2989-2716)提供一二線城市可以真實可靠快速安排30分鐘到達

- 三亞包夜學(xué)生妹(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 太原外圍(外圍女)外圍預(yù)約(電話微信181-2989-2716)真實上門外圍上門外圍女,快速安排30分鐘到達

- 貴陽包夜美女(電話微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 南京外圍大圈資源預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 珠海外圍(外圍預(yù)約)外圍包夜(電話微信181-2989-2716)一二線城市可以快速安排,真實上門外圍上門外圍女30分鐘到達

- 青島包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 重慶包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 重慶外圍價格查詢(電話微信181-2989-2716)重慶外圍女價格多少

- 長沙包夜學(xué)生妹(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 成都外圍(外圍模特)外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女,快速安排30分鐘到達

- 西安外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 常州外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 合肥外圍大圈美女(電話微信181-2989-2716)提供頂級外圍優(yōu)質(zhì)資源,可滿足你的一切要求

- 長沙美女上門預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 海口外圍(高端外圍)外圍女(電話微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 上海漂亮外圍外圍上門外圍女姐上門(電話微信181-2989-2716)提供1-2線城市外圍上門外圍女,真實可靠快速安排30分鐘到達

- 杭州外圍(杭州外圍女)外圍上門(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 杭州外圍(杭州外圍女)外圍上門(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 杭州外圍上門外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女,快速安排30分鐘到達

- 溫州外圍上門外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女,快速安排30分鐘到達

- 鄭州包夜外圍外圍上門外圍女(電話微信181-2989-2716)一二線熱門城市上門真實可靠快速安排30分鐘到達

- 南京包夜美女全套外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 成都外圍(成都外圍女)外圍上門(電話微信181-2989-2716)提供一二線城市大圈外圍女資源

- 太原同城美女約炮(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 石家莊美女約炮(電話微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 廈門高端美女上門外圍上門外圍女(電話微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 深圳外圍(外圍預(yù)約)外圍外圍上門外圍女(電話微信181-2989-2716)高端外圍預(yù)約,快速安排30分鐘到達

- 天津兼職網(wǎng)紅上門外圍上門外圍女(電話微信181-2989-2716)提供一二線城市真實上門外圍上門外圍女,快速安排30分鐘到達

- 深圳美女同城上門外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 海口外圍全球資源(電話微信181-2989-2716)海口外圍全球資源提供全國外圍高端商務(wù)模特伴游

- 重慶包夜美女全套外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 廣州同城外圍上門外圍女上門(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 湛頭包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 合肥包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 無錫同城約炮(電話微信181-2989-2716)提供頂級外圍優(yōu)質(zhì)資源,可滿足你的一切要求

- 寧波美女上門預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 湛頭包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 常州兼職外圍上門外圍女上門外圍上門外圍女(電話微信181-2989-2716)提供1-2線城市高端外圍預(yù)約,快速安排30分鐘到達

- 濟南外圍(濟南外圍女)外圍上門(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 哈爾濱外圍模特經(jīng)紀人(外圍預(yù)約)外圍女(電話微信181-2989-2716)一二線城市可以真實可靠快速安排

- 北京外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 廈門外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 溫州美女上門預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 深圳同城外圍上門外圍女上門(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 深圳美女兼職外圍上門外圍女(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 寧波外圍模特預(yù)約(外圍模特)外圍預(yù)約(電話微信181-2989-2716)一二線城市真實上門外圍上門外圍女,快速安排30分鐘到達

- 鄭州外圍(外圍預(yù)約)外圍女價格(電話微信181-2989-2716)提供一二線城市真實上門外圍上門外圍女,快速安排30分鐘到達

- 廣州外圍(廣州外圍女)外圍預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,優(yōu)質(zhì)資源可滿足你的一切要求

- 沈陽同城上門外圍上門外圍女(電話微信181-2989-2716)提供高端外圍上門真實靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達

- 深圳同城外圍約炮外圍上門外圍女(電話微信181-2989-2716)一二線城市上門真實可靠快速安排30分鐘到達

- 鄭州包夜美女全套外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 杭州外圍女模特平臺(外圍模特)外圍女(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達

- 上海同城包夜外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 重慶美女兼職外圍上門外圍女(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 深圳外圍(深圳外圍女)(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 杭州外圍價格查詢(電話微信181-2989-2716)杭州外圍女價格多少

- 太原美女包養(yǎng)(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 上海外圍(上海外圍女)外圍上門(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 蘇州美女包養(yǎng)(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 長沙同城美女約炮(電話微信181-2989-2716)無套吹簫、配合各種姿勢

- 湛頭提包夜美女(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 杭州同城約炮(電話微信181-2989-2716)提供頂級外圍優(yōu)質(zhì)資源,可滿足你的一切要求

- 重慶外圍(外圍預(yù)約)外圍女聯(lián)系方式(電話微信181-2989-2716)一二線熱門城市上門

- 海口同城外圍上門外圍女上門(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 杭州高端美女上門外圍上門外圍女(電話微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 石家莊外圍美女(電話微信181-2989-2716)提供頂級外圍,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 常州包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 上海外圍(上海外圍女)外圍預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,優(yōu)質(zhì)資源可滿足你的一切要求

- 南京外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 濟南同城美女預(yù)約外圍上門外圍女(電話微信181-2989-2716)提供全套一條龍外圍上門外圍女

- 麗江外圍外圍上門外圍女全套(電話微信181-2989-2716)麗江真實可靠快速安排

- 廣州外圍女在線(電話微信181-2989-2716)預(yù)約自帶工作室外圍上門外圍女不收任何定金

- 麗江外圍模特預(yù)約(外圍經(jīng)紀人)外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女快速安排30分鐘到達

- 溫州美女約炮(電話微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 上海外圍(外圍預(yù)約)外圍女價格(電話微信181-2989-2716)提供一二線城市真實上門外圍上門外圍女,快速安排30分鐘到達

- 貴陽同城上門外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 麗江外圍上門(麗江外圍預(yù)約外圍上門外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 濟南外圍(濟南外圍女)外圍外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 太原外圍預(yù)約平臺(外圍上門)外圍預(yù)約(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 上海外圍女(上海外圍模特)電話微信181-2989-2716提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 深圳包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 蘇州外圍價格查詢(電話微信181-2989-2716)蘇州外圍女價格多少

- 杭州外圍(外圍模特)外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女,快速安排30分鐘到達

- 北京漂亮外圍外圍上門外圍女姐上門(電話微信181-2989-2716)提供1-2線城市外圍上門外圍女,真實可靠快速安排30分鐘到達

- 長春同城上門外圍上門外圍女(電話微信181-2989-2716)提供高端外圍上門真實靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達

- 深圳同城上門外圍上門外圍女(電話微信181-2989-2716)提供高端外圍上門真實靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達

- 貴陽兼職模特包夜外圍上門外圍女(電話微信181-2989-2716)模特伴游預(yù)約全套一條龍外圍上門外圍女包夜

- 深圳外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 太原外圍(外圍預(yù)約)(電話微信181-2989-2716)一二線城市有外圍資源網(wǎng)紅模特空姐留學(xué)生白領(lǐng)

- 臺州美女兼職外圍上門外圍女(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 太原美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 海口外圍(海口外圍女)外圍預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,優(yōu)質(zhì)資源可滿足你的一切要求

- 鄭州外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 太原外圍哪里有(電話微信181-2989-2716)一二線城市空姐模特大學(xué)生網(wǎng)紅上門外圍上門外圍女

- 青島美女上門聯(lián)系方式(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 臺州外圍上門(臺州外圍預(yù)約外圍上門外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 海口漂亮外圍外圍上門外圍女姐上門(電話微信181-2989-2716)提供1-2線城市外圍上門外圍女,真實可靠快速安排30分鐘到達

- 臺州外圍(臺州外圍女)電話微信181-2989-2716提供一二線城市外圍預(yù)約、空姐、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 三亞同城外圍約炮外圍上門外圍女(電話微信181-2989-2716)一二線城市上門真實可靠快速安排30分鐘到達

- 武漢美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 南京外圍女模特平臺(外圍預(yù)約)電話微信181-2989-2716提供頂級外圍女上門,可滿足你的一切要求

- 昆明兼職模特包夜外圍上門外圍女(電話微信181-2989-2716)模特伴游預(yù)約全套一條龍外圍上門外圍女包夜

- 重慶兼職模特包夜外圍上門外圍女(電話微信181-2989-2716)模特伴游預(yù)約全套一條龍外圍上門外圍女包夜

- 深圳外圍(外圍模特)外圍女(電話微信181-2989-2716)提供高端外圍上門真實靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達

- 廈門外圍(外圍預(yù)約)外圍外圍上門外圍女(電話微信181-2989-2716)高端外圍預(yù)約,快速安排30分鐘到達

- 無錫外圍女靠譜(電話微信181-2989-2716)無錫外圍女那個靠譜啊

- 杭州模特包夜(電話微信181-2989-2716)提供一二線城市可以真實可靠快速安排30分鐘到達

- 上海同城美女預(yù)約外圍上門外圍女(電話微信181-2989-2716)提供全套一條龍外圍上門外圍女

- 重慶外圍(外圍經(jīng)紀)外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女快速安排30分鐘到達

- 寧波外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 三亞外圍(外圍模特)外圍女(電話微信181-2989-2716)提供高端外圍上門真實靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達

- 貴陽外圍預(yù)約上門(電話微信181-2989-2716)安全可靠真實安排見人滿意付款

- 昆明包夜美女外圍上門外圍女(電話微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 義烏外圍(外圍模特)外圍預(yù)約(電話微信181-2989-2716)提供高端外圍上門真實靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達

- 天津包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 西安外圍模特經(jīng)紀人(外圍預(yù)約)外圍女(電話微信181-2989-2716)一二線城市可以真實可靠快速安排

- 深圳外圍(外圍預(yù)約)外圍外圍上門外圍女(電話微信181-2989-2716)高端外圍預(yù)約,快速安排30分鐘到達

- 上海外圍(高端外圍)外圍女(電話微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 廣州外圍上門(廣州外圍預(yù)約外圍上門外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 杭州外圍女模特平臺(外圍預(yù)約)電話微信181-2989-2716提供頂級外圍女上門,可滿足你的一切要求

- 重慶包夜美女全套外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 上海包夜美女(電話微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 天津外圍預(yù)約平臺(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 南京外圍模特經(jīng)紀人(外圍預(yù)約)外圍女(電話微信181-2989-2716)一二線城市可以真實可靠快速安排

- 上海外圍(外圍女)外圍預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,優(yōu)質(zhì)資源可滿足你的一切要求

- 貴陽高端美女上門外圍上門外圍女(電話微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 西安同城約炮(電話微信181-2989-2716)提供頂級外圍優(yōu)質(zhì)資源,可滿足你的一切要求

- 南昌美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 蘇州模特包夜(電話微信181-2989-2716)提供一二線城市可以真實可靠快速安排30分鐘到達

- 北京包夜學(xué)生妹(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 湛頭外圍美女(電話微信181-2989-2716)提供頂級外圍,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 南京外圍(南京外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 杭州包夜外圍外圍上門外圍女(電話微信181-2989-2716)一二線熱門城市上門真實可靠快速安排30分鐘到達

- 臺州包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 湛頭包夜美女(電話微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 濟南外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 杭州同城上門外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 無錫提包夜美女(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 西安外圍外圍上門外圍女全套(電話微信181-2989-2716)西安真實可靠快速安排

- 上海包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 臺州外圍大圈美女(電話微信181-2989-2716)提供頂級外圍優(yōu)質(zhì)資源,可滿足你的一切要求

- 珠海包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 貴陽外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 貴陽同城外圍上門外圍女上門(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 長春外圍女靠譜(電話微信181-2989-2716)長春外圍女那個靠譜啊

- 哈爾濱美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 福州包夜外圍外圍上門外圍女(電話微信181-2989-2716)一二線熱門城市上門真實可靠快速安排30分鐘到達

- 寧波包夜學(xué)生妹(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 廣州美女兼職上門外圍上門外圍女(電話微信181-2989-2716)全國1-2線城市可真實安排30分鐘到達,不收任何定金

- 無錫外圍上門(無錫外圍預(yù)約外圍上門外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 廈門外圍女上門外圍上門外圍女(電話微信181-2989-2716)一二線及海外城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 昆明外圍(外圍模特)外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女,快速安排30分鐘到達

- 貴陽包夜美女(電話微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 沈陽美女包養(yǎng)(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 成都外圍預(yù)約平臺(外圍上門)外圍預(yù)約(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 南通美女上門聯(lián)系方式(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 麗江外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 成都外圍(外圍女包夜)外圍預(yù)約(電話微信181-2989-2716)全球及一二線城市外圍夜店妹子緩交一夜情

- 重慶外圍(外圍模特)外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女,快速安排30分鐘到達

- 長春包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 太原外圍預(yù)約平臺(外圍上門)外圍預(yù)約(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 湛頭外圍價格查詢(電話微信181-2989-2716)湛頭外圍女價格多少

- 海口包夜美女全套外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 石家莊外圍模特媛交一夜情(電話微信181-2989-2716)石家莊外圍真實可靠快速安排

- 天津美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 臺州同城外圍上門外圍女上門(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 珠海外圍(外圍女)外圍預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,優(yōu)質(zhì)資源可滿足你的一切要求

- 長沙美女同城上門外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 珠海外圍價格查詢(電話微信181-2989-2716)珠海外圍女價格多少

- 無錫美女上門預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 寧波外圍全球資源(電話微信181-2989-2716)寧波外圍全球資源提供全國外圍高端商務(wù)模特伴游

- 揚州外圍模特經(jīng)紀人(外圍預(yù)約)外圍女(電話微信181-2989-2716)一二線城市可以真實可靠快速安排

- 深圳外圍電話(電話微信181-2989-2716)深圳外圍外圍上門外圍女真實可靠快速安排

- 溫州外圍大圈資源預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 南京外圍模特經(jīng)紀人(外圍預(yù)約)外圍女(電話微信181-2989-2716)一二線城市可以真實可靠快速安排

- 北京外圍(外圍預(yù)約)外圍女聯(lián)系方式(電話微信181-2989-2716)一二線熱門城市上門

- 成都同城上門外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 無錫外圍女那個靠譜(電話微信181-2989-2716)無錫外圍真實可靠快速安排

- 合肥同城美女預(yù)約外圍上門外圍女(電話微信181-2989-2716)提供全套一條龍外圍上門外圍女

- 北京包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 太原同城約炮(電話微信181-2989-2716)提供頂級外圍優(yōu)質(zhì)資源,可滿足你的一切要求

- 青島美女上門聯(lián)系方式(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 常州模特包夜(電話微信181-2989-2716)提供一二線城市可以真實可靠快速安排30分鐘到達

- 常州外圍預(yù)約上門(電話微信181-2989-2716)提供高端外圍上門真實靠譜快速安排不收定金見人滿意付款

- 貴陽美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 無錫外圍價格查詢(電話微信181-2989-2716)無錫外圍女價格多少

- 長沙外圍上門(長沙外圍預(yù)約外圍上門外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 太原美女約炮(電話微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 上海同城美女約炮(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 常州包夜外圍外圍上門外圍女(電話微信181-2989-2716)一二線熱門城市上門真實可靠快速安排30分鐘到達

- 南昌高端美女上門外圍上門外圍女(電話微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 貴陽模特包夜(電話微信181-2989-2716)提供一二線城市可以真實可靠快速安排30分鐘到達

- 海口同城美女約炮(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 臺州外圍(外圍預(yù)約)外圍外圍上門外圍女(電話微信181-2989-2716)高端外圍預(yù)約,快速安排30分鐘到達

- 常州外圍模特經(jīng)紀人(外圍預(yù)約)外圍女(電話微信181-2989-2716)一二線城市可以真實可靠快速安排

- 南京美女兼職外圍上門外圍女(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 常州外圍女資料(電話微信181-2989-2716)一二線城市均可安排高端外圍資源

- 沈陽外圍上門外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女,快速安排30分鐘到達

- 長春包夜外圍(電話微信181-2989-2716)一二線城市模特空姐網(wǎng)紅學(xué)生上門

- 上海外圍預(yù)約(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 廈門外圍(外圍預(yù)約)外圍女價格(電話微信181-2989-2716)提供一二線城市真實上門外圍上門外圍女,快速安排30分鐘到達

- 溫州包夜學(xué)生妹(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 澳門外圍(澳門外圍女)外圍上門(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 鄭州外圍(鄭州外圍女)外圍外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 廣州同城上門外圍上門外圍女(電話微信181-2989-2716)提供高端外圍上門真實靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達

- 天津包夜外圍外圍上門外圍女(電話微信181-2989-2716)一二線熱門城市上門真實可靠快速安排30分鐘到達

- 石家莊外圍女上門外圍上門外圍女(電話微信181-2989-2716)一二線及海外城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 杭州兼職學(xué)生妹(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 深圳美女兼職外圍上門外圍女(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 北京包夜美女(電話微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 福州兼職美女上門外圍上門外圍女包夜(電話微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女一條龍全套包夜

- 北京同城外圍上門外圍女上門(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 昆明包夜外圍(電話微信181-2989-2716)一二線城市模特空姐網(wǎng)紅學(xué)生上門

- 沈陽提包夜美女(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 廣州外圍預(yù)約(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 西安外圍女上門外圍上門外圍女(電話微信181-2989-2716)一二線及海外城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 福州同城美女約炮(電話微信181-2989-2716)無套吹簫、配合各種姿勢

- 常州包夜學(xué)生妹(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 長沙外圍(長沙外圍女)外圍聯(lián)系方式(電話微信181-2989-2716)1-2線城市快速安排,真實到達無任何定金

- 上海外圍(外圍預(yù)約)(電話微信181-2989-2716)一二線城市有外圍資源網(wǎng)紅模特空姐留學(xué)生白領(lǐng)

- 貴陽外圍模特預(yù)約(外圍經(jīng)紀人)外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 常州包夜外圍外圍上門外圍女(電話微信181-2989-2716)一二線熱門城市上門真實可靠快速安排30分鐘到達

- 南京外圍上門(南京外圍預(yù)約外圍上門外圍女)電話微信181-2989-2716一二線城市外圍預(yù)約、空姐、模特、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 杭州外圍女(杭州外圍模特)電話微信181-2989-2716提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 珠海美女包養(yǎng)(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 北京美女兼職上門外圍上門外圍女(電話微信181-2989-2716)全國1-2線城市可真實安排30分鐘到達,不收任何定金

- 太原外圍女模特平臺(外圍預(yù)約)電話微信181-2989-2716提供頂級外圍女上門,可滿足你的一切要求

- 常州美女兼職外圍上門外圍女(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 上海外圍女照片(電話微信181-2989-2716)上海外圍女照片漂亮極品一炮打響

- 南通外圍預(yù)約上門(電話微信181-2989-2716)提供高端外圍上門真實靠譜快速安排不收定金見人滿意付款

- 重慶外圍模特經(jīng)紀人(外圍預(yù)約)外圍女(電話微信181-2989-2716)一二線城市可以真實可靠快速安排

- 青島外圍(香港外圍女)外圍上門(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 沈陽外圍模特媛交一夜情(電話微信181-2989-2716)沈陽外圍真實可靠快速安排

- 寧波外圍大圈伴游(電話微信181-2989-2716)真實上門外圍上門外圍女快速安排30分鐘到達

- 杭州漂亮外圍外圍上門外圍女姐上門(電話微信181-2989-2716)提供1-2線城市外圍上門外圍女,真實可靠快速安排30分鐘到達

- 常州外圍(外圍預(yù)約)外圍女價格(電話微信181-2989-2716)提供一二線城市真實上門外圍上門外圍女,快速安排30分鐘到達

- 長春模特包夜(電話微信181-2989-2716)提供一二線城市可以真實可靠快速安排30分鐘到達

- 南昌外圍模特預(yù)約(外圍經(jīng)紀人)外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 北京美女上門預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 杭州包夜美女(電話微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 上海美女約炮(電話微信181-2989-2716)大保健可上門安排外圍外圍上門外圍女桑拿全套按摩

- 香港外圍模特經(jīng)紀人(外圍預(yù)約)外圍女(電話微信181-2989-2716)一二線城市可以真實可靠快速安排

- 南京外圍模特經(jīng)紀人(外圍預(yù)約)(電話微信181-2989-2716)提供1-2線城市高端外圍預(yù)約快速安排30分鐘到達

- 太原外圍價格查詢(電話微信181-2989-2716)太原外圍女價格多少

- 石家莊包夜外圍外圍上門外圍女(電話微信181-2989-2716)一二線熱門城市上門真實可靠快速安排30分鐘到達

- 濟南同城美女約炮(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 北京美女兼職外圍上門外圍女(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 三亞外圍(外圍預(yù)約)外圍女價格(電話微信181-2989-2716)提供一二線城市真實上門外圍上門外圍女,快速安排30分鐘到達

- 上海外圍(外圍女包夜)外圍預(yù)約(電話微信181-2989-2716)全球及一二線城市外圍夜店妹子緩交一夜情

- 南京包夜外圍(電話微信181-2989-2716)一二線城市模特空姐網(wǎng)紅學(xué)生上門

- 寧波外圍(寧波外圍女)外圍預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,優(yōu)質(zhì)資源可滿足你的一切要求

- 杭州外圍(外圍預(yù)約)外圍聯(lián)系方式(電話微信181-2989-2716)1-2線城市同城快速安排,30分鐘準時到達

- 太原兼職模特包夜外圍上門外圍女(電話微信181-2989-2716)模特伴游預(yù)約全套一條龍外圍上門外圍女包夜

- 杭州外圍(杭州外圍女)外圍上門(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 深圳包夜美女全套外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 太原外圍電話(電話微信181-2989-2716)太原外圍外圍上門外圍女真實可靠快速安排

- 北京美女同城上門外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 上海外圍(外圍模特)外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女,快速安排30分鐘到達

- 青島美女上門預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 南京包養(yǎng)外圍上門外圍女上門外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 濟南外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 武漢同城外圍上門外圍女上門(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 北京外圍(外圍女包夜)外圍預(yù)約(電話微信181-2989-2716)全球及一二線城市外圍夜店妹子緩交一夜情

- 杭州外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 成都美女包養(yǎng)(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 福州外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 臺州高端美女上門外圍上門外圍女(電話微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女

- 太原外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 寧波外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 廣州同城美女預(yù)約外圍上門外圍女(電話微信181-2989-2716)提供全套一條龍外圍上門外圍女

- 長春包夜美女全套外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 深圳美女上門聯(lián)系方式(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 寧波兼職美女上門外圍上門外圍女包夜(電話微信181-2989-2716)提供全球及一二線城市兼職美女上門外圍上門外圍女一條龍全套包夜

- 南昌外圍(外圍經(jīng)紀)外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女快速安排30分鐘到達

- 澳門外圍預(yù)約(外圍上門)外圍外圍上門外圍女(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 上海外圍價格查詢(電話微信181-2989-2716)上海外圍女價格多少

- 武漢外圍價格查詢(電話微信181-2989-2716)武漢外圍女價格多少

- 廣州包夜美女外圍上門外圍女(電話微信181-2989-2716)提供全國及一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源覆蓋全國

- 濟南外圍女模特平臺(外圍預(yù)約)電話微信181-2989-2716提供頂級外圍女上門,可滿足你的一切要求

- 天津包夜美女(電話微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 廣州兼職白領(lǐng)上門外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 常州同城外圍上門外圍女上門(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 福州同城外圍上門外圍女上門(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 長沙外圍(外圍經(jīng)紀)外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女快速安排30分鐘到達

- 上海外圍女模特平臺(外圍模特)外圍女(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達

- 廈門外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 天津同城美女約炮(電話微信181-2989-2716)無套吹簫、配合各種姿勢

- 北京包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 杭州兼職外圍女上門全套包夜(電話微信181-2989-2716)高端外圍預(yù)約快速安排30分鐘到達

- 珠海包夜外圍上門外圍女姐(電話微信181-2989-2716)一二線城市均可安排、高端一手資源、高質(zhì)量外圍女模特空姐、學(xué)生妹應(yīng)有盡有

- 珠海同城上門外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,可滿足你的一切要求

- 上海包夜美女(電話微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 三亞美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 鎮(zhèn)江外圍(外圍女包夜)外圍預(yù)約(電話微信181-2989-2716)全球及一二線城市外圍夜店妹子緩交一夜情

- 深圳美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 南昌兼職網(wǎng)紅上門外圍上門外圍女(電話微信181-2989-2716)提供一二線城市真實上門外圍上門外圍女,快速安排30分鐘到達

- 哈爾濱外圍(外圍經(jīng)紀)外圍女(電話微信181-2989-2716)真實上門外圍上門外圍女快速安排30分鐘到達

- 麗江同城約炮(電話微信181-2989-2716)提供頂級外圍優(yōu)質(zhì)資源,可滿足你的一切要求

- 鄭州外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 上海美女兼職外圍上門外圍女(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 海口美女上門聯(lián)系方式(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 武漢包夜美女(電話微信181-2989-2716)一二線城市高端商務(wù)模特伴游、空姐、大學(xué)生、少婦、明星等優(yōu)質(zhì)資

- 昆明外圍(昆明外圍女)電話微信181-2989-2716提供一二線城市高端外圍預(yù)約,快速安排30分鐘到達

- 貴陽外圍(貴陽外圍女)外圍聯(lián)系方式(電話微信181-2989-2716)1-2線城市快速安排,真實到達無任何定金

- 珠海外圍女模特平臺(外圍預(yù)約)電話微信181-2989-2716提供頂級外圍女上門,可滿足你的一切要求

- 北京同城外圍約炮外圍上門外圍女(電話微信181-2989-2716)一二線城市上門真實可靠快速安排30分鐘到達

- 北京同城上門外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 南昌包夜空姐預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 珠海外圍上門外圍女(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 上海同城美女約炮(電話微信181-2989-2716)無套吹簫、配合各種姿勢

- 太原外圍女(太原外圍模特)電話微信181-2989-2716提供頂級外圍女上門,伴游,空姐,網(wǎng)紅,明星,車模等優(yōu)質(zhì)資源,可滿足你的一切要求

- 太原美女包養(yǎng)(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 太原包夜學(xué)生妹(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 鎮(zhèn)江美女快餐外圍上門外圍女(電話微信181-2989-2716)提供1-2線熱門城市快速安排30分鐘到達

- 廈門美女上門預(yù)約(電話微信181-2989-2716)提供頂級外圍女上門,可滿足你的一切要求

- 珠海兼職空姐包夜外圍上門外圍女(電話微信181-2989-2716)兼職空姐包夜外圍上門外圍女緩交一夜情、全套一條龍外圍上門外圍女

- 南昌外圍女資料(電話微信181-2989-2716)一二線城市均可安排高端外圍資源

- 鄭州外圍(高端外圍)外圍模特(電話微信181-2989-2716)一二線城市外圍預(yù)約外圍上門外圍女,不收任何定金30分鐘內(nèi)快速到達

- 上海包夜學(xué)生妹(電話微信181-2989-2716)一二線城市外圍模特伴游預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 深圳美女兼職外圍上門外圍女(電話微信181-2989-2716)一二線城市預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 沈陽外圍(外圍女)外圍上門(電話微信181-2989-2716)提供高端外圍上門真實靠譜快速安排不收定金見人滿意付30分鐘內(nèi)到達

- 南通外圍預(yù)約平臺(外圍上門)外圍預(yù)約(電話微信181-2989-2716)一二線城市外圍預(yù)約、空姐、模特、留學(xué)生、熟女、白領(lǐng)、老師、優(yōu)質(zhì)資源

- 蘇州(大保健)上門服務(wù)電話崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 上海虹口區(qū)高級外圍女上門資源崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 香港找酒店上門服務(wù)電崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 上海靜安區(qū)外圍女上門找外圍服務(wù)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 上海黃埔區(qū)怎么約小姐酒店上門崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 杭州錢塘區(qū)美女啪啪啪(外圍資源)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 成都武侯區(qū)外圍(洋馬)外圍崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 佛山南海區(qū)怎么找(外圍模特)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 蘇州酒店上門服務(wù)靠譜電崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 北京海淀區(qū)外圍介紹的電話聯(lián)系方式 崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 蘇州姑蘇區(qū)外圍(外圍抖音網(wǎng)紅)外圍崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 南京約美女上門提供高端外圍女真實安排崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 澳門外圍商務(wù)模特(外圍)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 佛山順德區(qū)(小姐過夜服務(wù))小姐崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 廈門高端外圍經(jīng)紀人的聯(lián)系方式崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 南京江寧區(qū)(外圍經(jīng)紀人)外圍服務(wù)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 鄭州可以提供上門服務(wù)的APP軟件崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 成都錦江區(qū)外圍預(yù)約(高端外圍)外圍崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 杭州濱江區(qū)找妹子(大圈外圍)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 杭州拱墅區(qū)(上門全套服務(wù))上門服務(wù)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 佛山南海區(qū)全套上門(全套資源)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 武漢漢陽區(qū)小妹按摩崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 上海徐匯區(qū)高端外圍女崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 天津紅橋區(qū)外圍(高級資源)真實外圍女上門外圍大學(xué)生崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 鄭州二七區(qū)美女上門特殊服務(wù)(美女上門)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 廣州荔灣區(qū)(外圍)資源聯(lián)系方式崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 杭州富陽區(qū)外圍高端美女(美女模特)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 大連中山區(qū)(大保健)上門服務(wù)電話崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 廣州花都區(qū)高級資源上門按摩服務(wù)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 貴陽花溪區(qū)(全套服務(wù))上門服務(wù)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 佛山外圍小姐空降崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 杭州臨平區(qū)大學(xué)生空乘兼職上門服務(wù)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 溫州(按摩SPA上門服務(wù))按摩崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 鄭州金水區(qū)上門按摩預(yù)約電話崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 武漢江岸區(qū)(小姐上門按摩)小姐崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 武漢外圍(洋馬)外圍崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 佛山順德區(qū)全套按摩(同城附近約崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 蘇州各區(qū)品茶場子找酒店上門(同城酒店上門)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 長沙雨花區(qū)同城附近約(同城美女約炮)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 天津河北區(qū)(大活)上門崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 天津津南區(qū)外圍上門服務(wù)(高級資源)外圍崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 杭州上城區(qū)外圍上門做愛崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 杭州拱墅區(qū)外圍聯(lián)系方式崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 北京宣武區(qū)(小姐按摩服務(wù))找小姐崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 青島美女上門特殊服務(wù)(美女上門)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 大連甘井子區(qū)外圍女外圍預(yù)約崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 西安灞橋區(qū)(300一次)的外圍服務(wù)怎么找崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 合肥(小姐約炮)約炮崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 大連金州區(qū)(300一次)的外圍服務(wù)怎么找崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 長春小妹按摩崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 西安雁塔區(qū)外圍女外圍預(yù)約崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 武漢漢陽區(qū)同城附近約(同城美女約炮)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 長沙望城區(qū)高級資源上門服務(wù)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 佛山高明區(qū)約炮(高質(zhì)量美女約炮)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 合肥廬陽區(qū)(小姐援交)援交小姐崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 重慶特殊服務(wù)(全套服務(wù))崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 鄭州外圍(洋酒)外圍服務(wù)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 蘇州各區(qū)品茶場子找外圍空姐(外圍)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 三亞高級資源崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 青島(酒店上門服務(wù))聯(lián)系方式崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 蘇州外圍女模特平臺高端外圍崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 杭州西湖區(qū)外圍(外圍抖音網(wǎng)紅)外圍崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 北京豐臺區(qū)約炮(高質(zhì)量美女約炮)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 哈爾濱找小姐(色情服務(wù))找小姐崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 蘇州姑蘇區(qū)(小姐)小姐過夜服務(wù)崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 天津東麗區(qū)(按摩全套服務(wù)上門)按摩崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款

- 蘇州找外圍(抖音網(wǎng)紅)找外圍崴信159+8298+6630提供外圍女小姐上門服務(wù)快速安排面到付款